Krajowe centra superkomputerowe w Stanach Zjednoczonych, Europie i Chinach są nie tylko wystarczająco bogate, aby budować niezwykle potężne maszyny, ale także wystarczająco bogate, dzięki rządom krajowym, aby zapewnić i wspierać wiele, nieco niezgodnych architektur, aby zabezpieczyć swoje zakłady i złagodzić ryzyko ryzyko.

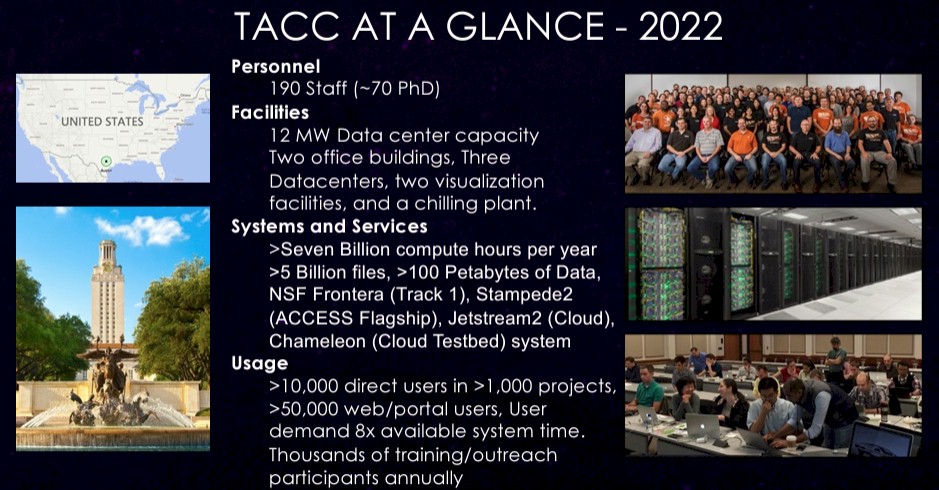

W Stanach Zjednoczonych Narodowa Fundacja Nauki, która współpracuje z Departamentem Energii, woli pozostawić otwarte opcje, jak widzieliśmy na łamach… Następna platforma W ciągu ostatniej dekady dzięki Texas Center for Advanced Computing na Uniwersytecie Teksasu, flagowej placówce NSF, zaobserwowano wystarczające zainteresowanie i środki finansowe, aby w ramach TACC zapewnić wiele architektur od różnych dostawców.

Ostatecznie jednak w TACC wybrano pojedynczy silnik obliczeniowy dla platformy, a wraz z niedawnym wprowadzeniem na rynek hybrydowego klastra CPU-GPU „Vista” w placówce przygotowano grunt pod trójstronny wyścig pomiędzy firmami Intel, AMD i Nvidia będzie dostawcą silników obliczeniowych dla przyszłego superkomputera „Horizon”. Jej misją jest osiągnięcie 10 razy większej szybkości niż obecny superkomputer Frontera, wyposażony w cały procesor, którego budowa kosztowała 60 milionów dolarów i został zainstalowany w 2019 roku.

Przed problemami z liniami produkcyjnymi Intela i pandemią wirusa TACC spodziewał się, że druga faza działań następczych Frontery, być może z jakimś akceleratorem zapewniającym większość lub większość jej możliwości obliczeniowych, zostanie dostarczona w 2021 r., ale zamiast tego TACC zmodernizował swój „Lonestar” Towarzyszący Stampede działał na 8008 dwugniazdowych węzłach Xeon SP „Cascade Lake”, które miały 448 448 rdzeni i 38,7 petaflopów wydajności.

Lonestar 6, który zostanie zainstalowany w 2021 roku, jest oparty na procesorach AMD „Milan” Epyc 7763 i ma 71 680 rdzeni, które zapewniają 3 petaflopy szczytowej grawitacji F64 za 8,4 miliona dolarów.

Stampede 3 został zainstalowany w zeszłym roku i wkrótce trafi do produkcji. W Stampede 3 zachowano 1064 węzły Intel „Skylake” Xeon SP i 224 węzły „Ice Lake” Xeon SP używane w poprzednim systemie Stampede 2 i dodano 560 węzłów w oparciu o procesory Intel Max Series „Sapphire Rapids”, które są wyposażone w pamięć HBM2e, zbiera dane łącznie 137 952 rdzeni (w tym niektóre węzły testowe korzystające z akceleratorów serii GPU Max „Ponte Vecchio” firmy Intel) i nieco poniżej 10 petaflopów w szczycie przy rozdzielczości FP64.

W przypadku Visty Nvidia zabrała się do pracy. Vista jest wyposażona w chipset 600 Ultra, który łączy 72-rdzeniowy procesor serwerowy Arm „Grace” CG100 z akceleratorem graficznym GH100 „Hopper” w spójnej pamięci. Same silniki wektorowe w procesorach graficznych H100 zapewniają 20,4 petaflopów maksymalnej wydajności FP64, a można ją podwoić do 40,2 teraflopów przy FP64 na wbudowanych modułach matematycznych matrycy H100. Zasadniczo Vista ma tyle samo mocy co Frontera – oczywiście pod warunkiem, że możesz przenosić kod z procesorów na procesory graficzne. Teoretycznie więc wystarczyłoby tylko dziesięć komputerów Vista połączonych razem, aby uzyskać surową wydajność 10 razy większą niż Frontera – co jest celem przyszłego superkomputera Horizon, który ma zostać umieszczony w nowym, najwyższej klasy ośrodku obliczeniowym, który TACC buduje na obrzeżach Austin w połączeniu z Zmiana operatora współdzielonego centrum danych.

Obiekt, znany jako The Rock, jest piątą co do wielkości lokalizacją centrum danych obsługiwaną przez Switch, dołączając do centrów danych obsługiwanych przez tę firmę w Reno, Las Vegas, Atlancie i Grand Rapids. Tak będzie wyglądać część terenu w Austin, w której będzie zlokalizowany superkomputer Horizon:

A tak będzie wyglądał kompleks centrum danych The Rock zbudowany przez Switcha:

Projekt TACC przyjął bardzo daleko idącą perspektywę przy projektowaniu przyszłego superkomputera Horizon i obiektu LCCF, w którym będzie on mieścił ten i inne superkomputery przyszłości. NFS We wrześniu 2020 roku sfinansował wstępne prace projektowe kwotą 3,5 miliona dolarówI teraz NSF poszukuje od 520 do 620 milionów dolarów na pełne sfinansowanie LCCF w latach 2024–2027. (To są lata budżetowe rządu USA kończące się 31 lipca tego roku.) Jednak w tym samym dokumencie znajduje się tabela pokazująca łączną kwotę 656 milionów dolarów wydanych do roku 2029. Z tej kwoty 40 milionów dolarów przeznacza się rocznie na funkcjonowanie funduszu.

Horizon stanowi dużą część tego budżetu, ale nie tak dużą, jak mogłoby się wydawać. Dan Stanzione, wiceprezes ds. badań na Uniwersytecie Teksasu i dyrektor wykonawczy TACC, dał nam pewien wgląd w myślenie o TACC, kiedy rozmawialiśmy o Stampede 3 i zbliżającym się urządzeniu Vista przed jego ogłoszeniem na konferencji superkomputerowej SC23 w Denver w zeszłym roku . Powiedzieliśmy wtedy, że gdybyśmy byli Stanzione, kupilibyśmy kilka maszyn Grace-Grace i kilka maszyn Grace-Hopper i wciągnęliśmy wszystkich trzech dostawców silników komputerowych w wojnę licytacyjną, a on tylko się roześmiał.

Może dlatego, że taki jest dokładnie plan.

Jednak w rzeczywistości zaprojektowanie systemu Horizon, który będzie pierwszą maszyną w LCCF, nie jest proste, biorąc pod uwagę różnorodność obciążeń NSF.

„Wiemy, że w przypadku aplikacji, które profilujemy dla Horizon, 40 procent z nich jest obecnie w dobrym stanie pod kątem procesorów graficznych” – mówi Stanzione. Następna platforma. „Ale to oznacza, że 60 procent naszych dużych aplikacji naukowych tak nie jest. Obiecałem więc, że będziemy mieć znaczący komponent procesora dla Horizon, mimo że zainwestuję dolary w mniej więcej tę samą partycję, co aplikacje. A zatem 40 procent dolarów GPU, co oznacza, że około 80 procent GPU wypada, ponieważ są cztery lub pięć razy tańsze pod względem permutacji szczytowej.

Nasze najlepsze przypuszczenie było takie, że Horizon będzie kosztował mniej więcej tyle samo, co maszyna „Blue Waters”. Cray został zbudowany dla Narodowego Centrum Zastosowań Superkomputerowych na Uniwersytecie Illinois w 2011 roku, który kosztował 188 milionów dolarów, co stanowi najwyższy poziom wydatków NSF na pojedynczy system. Stanzione podkreślił, że koszt systemu Horizon, który zbudujemy w 2025 r. i zaczniemy działać w 2026 r., nie będzie na tym poziomie i „nie będzie na co kichać”, nawet w porównaniu z 500 milionami dolarów, jakie kosztował system Frontier w Oak Ridge Zainstalowanie go dwa lata temu lub 400 milionów dolarów to koszt wkrótce wdrażanego systemu „El Capitan” w Lawrence Livermore National Laboratory. (Są to koszty systemu pomniejszone o jednorazowe koszty inżynieryjne, czyli NRE).

Pozostawia to pytanie o 10-krotny wzrost wydajności w porównaniu z Fronterą dla aktualnie działających na niej aplikacji.

Lars Kostrky, jeden ze 190 badaczy w TACC, wygłosił prezentację na temat Frontery i Horizon w marcu 2023 r. Które znaleźliśmy dzisiaj, badając tę historię. To pokazuje, jak TACC stał się centralnym punktem HPC w Stanach Zjednoczonych:

Nawiasem mówiąc, moc znamionowa LCCF wynosi 15 megawatów w porównaniu do 12 megawatów, jakie ma obecnie moc znamionowa obiekt na kampusie Uniwersytetu w Teksasie. Jednak w tym przełączającym centrum danych poza Austin jest mnóstwo miejsca na rozbudowę i nie ma żadnych problemów z próbą zapewnienia większej mocy istniejącej lokalizacji TACC.

Proszę również zająć się tym: 7 miliardów godzin obliczeniowych rocznie i 5 miliardów plików. Jest to swego rodzaju hiperskaler. Zarządzanie dziesiątkami tysięcy użytkowników i tysiącami projektów nie jest łatwym zadaniem. Powiedzieliśmy to już wcześniej i powtórzymy: w pewnym sensie jest to łatwe na superskalę. Zarządzają kilkoma obciążeniami na dużą skalę. Jednak zarządzanie obciążeniami o rząd wielkości większymi to szczególny rodzaj koszmaru, gdy próbujesz zwiększyć wydajność do absolutnych granic. TACC jest prawdopodobnie najlepszym centrum HPC na świecie, które to potrafi, z czasem sprawności na poziomie 99,2% i wykorzystaniem na poziomie 95,4% w ramach 1,13 miliona stanowisk pracy wykonanych w ciągu 12 miesięcy poprzedzających prezentację Koesterke.

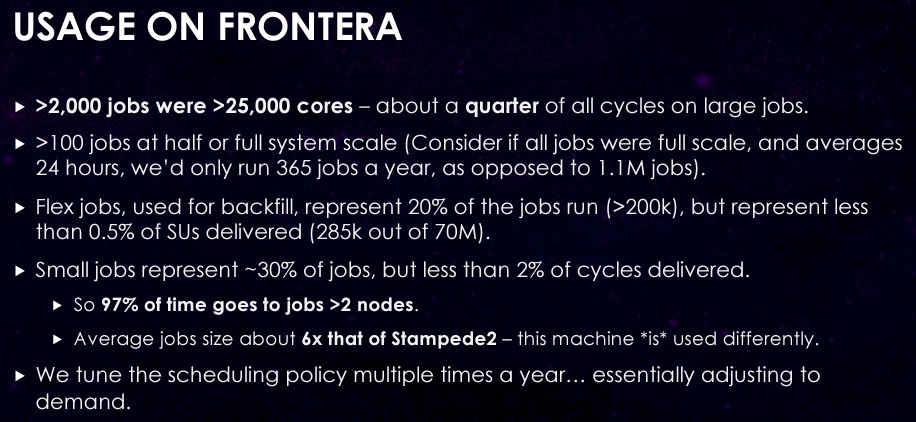

Oto koszmar, z którym musi sobie poradzić zespół Stanzione w TACC na swojej głównej maszynie:

To najbardziej szalona gra Tetris na świecie, a wysiłek moich menedżerów, aby tak się stało, jest świadectwem ludzkiego geniuszu.

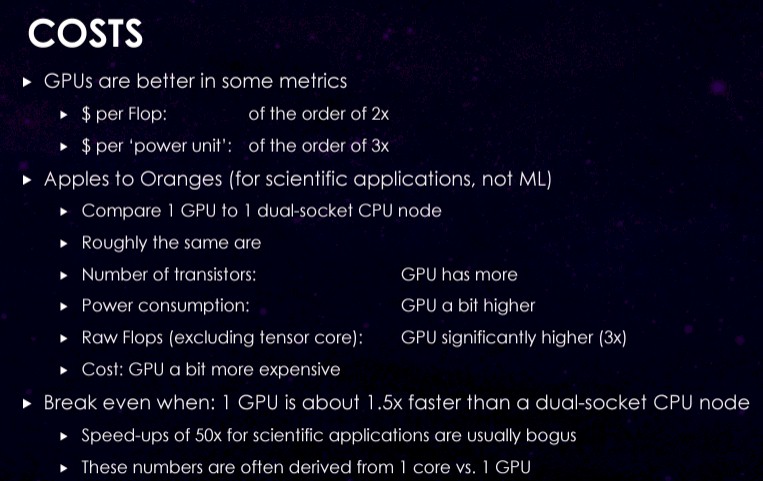

Oto jak TACC myśli o kosztach, opracowując architekturę przyszłego systemu Horizon:

Jest trochę prawdziwego świata, zimna woda na twarzy, o czym tłum HPC może pomyśleć.

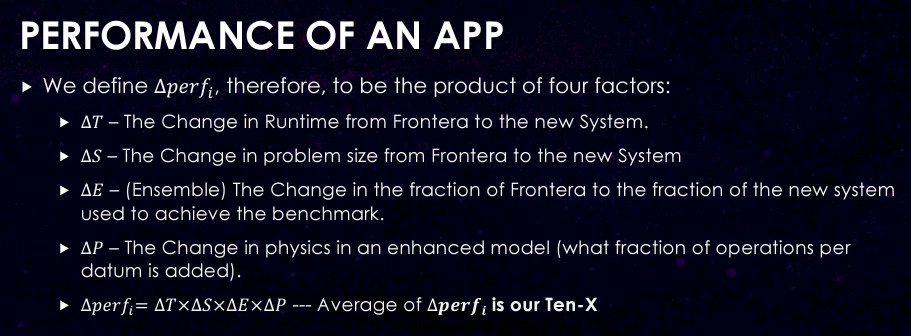

Wszystko to zostanie uwzględnione w projekcie Horizon, który naszym zdaniem będzie zawierał połączenie węzłów CPU-CPU i CPU-GPU, które zostały specjalnie zaprojektowane w celu zwiększenia wydajności aplikacji o docelowy poziom 10-krotnie w porównaniu z Fronterą. Koesterke twierdzi, że TACC bierze pod uwagę cztery czynniki, jeśli chodzi o wydajność aplikacji, i które przytaczamy:

- Czy zmienił się czas trwania zajęć? (Analog solidnego skalowania – wykonaj ten sam problem w krótszym czasie).

- Czy zmieniła się skala problemu? (Skalowanie analogowe do słabego – uruchamianie większych problemów w określonym czasie)

- Czy wykorzystaliśmy więcej, czy mniej niż wszystkie zasoby? (analog produktywności).

- Czy fizyka się zmieniła? (Nie ma dobrego analogu).

To prowadzi nas do rzeczywistych obszarów delta, które TACC będzie wykorzystywał przy projektowaniu Horizon:

Ich średnia zostanie obliczona jako pomnożenie czterech wymienionych powyżej czynników i nie wszystkie aplikacje będą się mnożyć w tym samym tempie w oparciu o te cztery czynniki, nawet na tym samym procesorze i karcie graficznej. Celem w ramach 20 „charakterystycznych zastosowań naukowych” lub CSA objętych Kostarki, które obejmują astronomię i astrofizykę, biofizykę i biologię, obliczeniową dynamikę płynów, geodynamikę i systemy ziemskie oraz inżynierię materiałową, jest uzyskanie 10-krotnego w dowolny sposób Ma to sens dla każdej indywidualnej aplikacji, biorąc pod uwagę naturę kodu i jego mapowanie na sprzęt.

Rzecz w tym, że niekoniecznie jest to tak proste, jak zbudowanie maszyny CPU-GPU o wydajności 400 petaflopów lub połączenie węzłów wyposażonych wyłącznie w procesor i węzłów akcelerowanych przez GPU, co daje łącznie 400 petaflopów i to w ciągu jednego dnia. TACC ma wiele różnych kodów i wielu różnych klientów, w przeciwieństwie do innych krajowych laboratoriów w USA, które często mają tylko kilka kodów głównych i dużo pieniędzy na przenoszenie kodu pomiędzy różnymi architekturami. Chociaż Frontera ma pewną liczbę wydajnych obciążeń, nie dominują one.

Z niecierpliwością czekamy na to, jak NSF i TACC przydzielają urządzenia do zadań. Wszyscy możemy się wiele nauczyć z budowy Horizon.

„Nieuleczalny myśliciel. Miłośnik jedzenia. Subtelnie czarujący badacz alkoholu. Zwolennik popkultury”.

More Stories

Kamery Google Nest będą teraz ostrzegać Cię, jeśli zostawisz otwartą bramę garażową

Anthropic, start-up zajmujący się sztuczną inteligencją, zostaje oskarżony o „rażącą eksplorację danych”.

Humble Games ogłosiło restrukturyzację, zwalniając cały zespół wydawniczy