Nowe badanie przez Butund zabo (Uniwersytet Bocconi w Mediolanie) kładzie podwaliny pod dokładniejsze, niezawodne i zrozumiałe metody obliczeń rozproszonych.

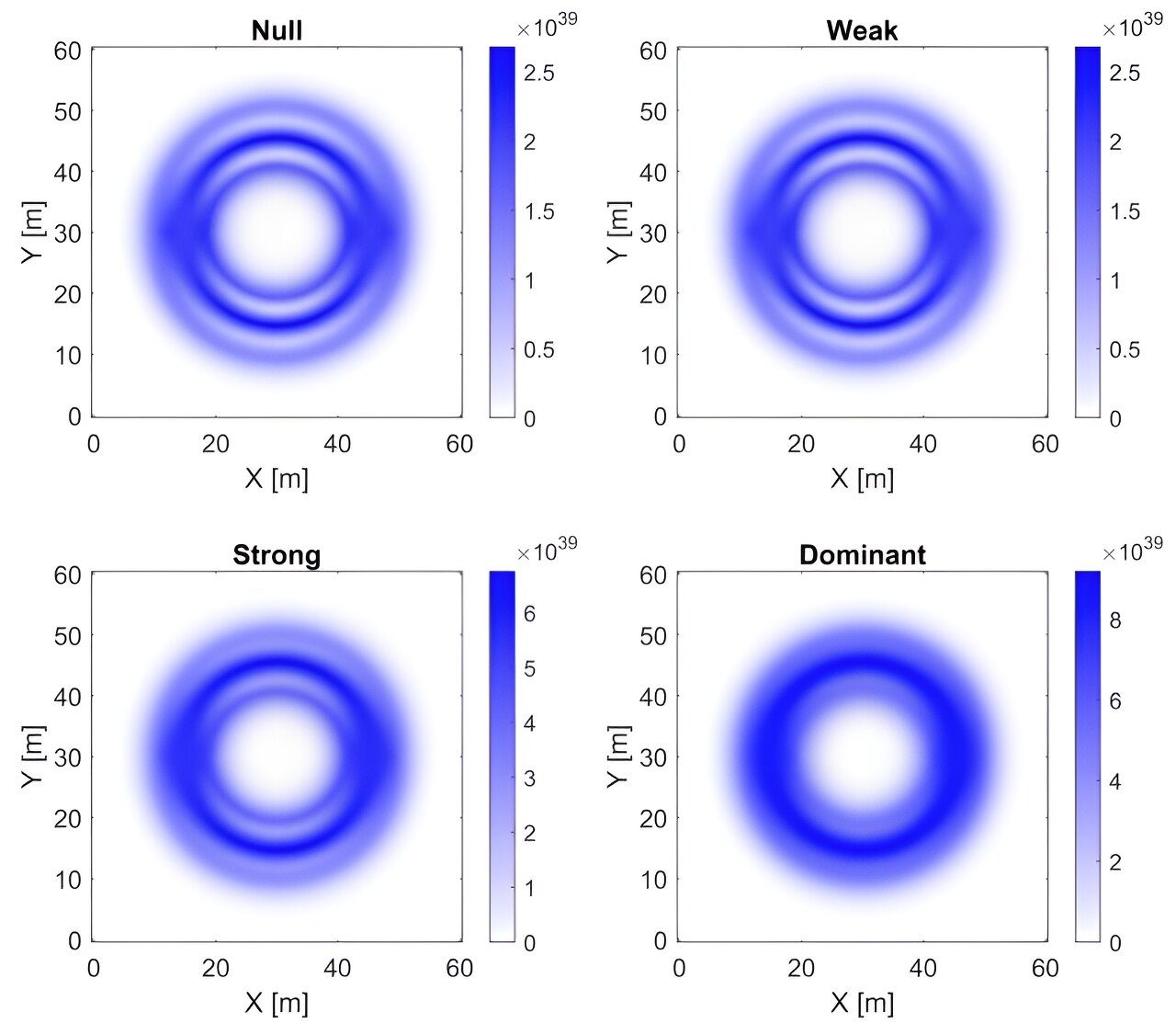

W świecie big data, gdy zachodzi potrzeba oszacowania wielu parametrów w bardzo złożonych modelach statystycznych, wykorzystujących dużą ilość dostępnych informacji, czas obliczeń staje się nie do utrzymania nawet w przypadku najszybszych superkomputerów. Jedną ze strategii opracowanych w celu poradzenia sobie z tym problemem jest przetwarzanie rozproszone (lub równoległe). Dane (lub w niektórych przypadkach zadania) są dzielone pomiędzy kilka urządzeń i jedynie sumaryczne informacje (wyniki obliczeń) przesyłane są do centralnej lokalizacji, takiej jak stacja meteorologiczna, obserwatorium astronomiczne czy system sterowania ruchem. Ta metoda łagodzi również obawy dotyczące prywatności, ponieważ większość danych nie wymaga przesyłania.

Jednak nawet przekazywanie między serwerami jedynie podsumowujących informacji może być kosztowne, a statystycy zapożyczyli od inżynierów elektryków pomysł ograniczania przepustowości. „Celem jest zminimalizowanie przepływu danych i utrata jak najmniejszej ilości informacji” – mówi profesor Szabo. „Co więcej, przetwarzanie równoległe to często procedura czarnej skrzynki, to znaczy procedura, która przekształca dane wejściowe w dane wyjściowe w niezbyt dobrze zrozumiałe, a to czyni wyniki niemożliwymi do interpretacji.” Całkowite i niewiarygodne. Pożądane byłoby znalezienie modeli matematycznych, które dałyby teoretyczne podstawy dla takich procedur. Profesor Szabo otrzymał grant ERBN mający na celu rozwiązanie takich problemów.

W swoim artykule z Lacy Forstein (Politechnika w Delft) i Harry’ego Van Zantena (Vrije Universiteit Amsterdam)profesor Szabo wyprowadza najlepsze testy minimalizacji utraty informacji w środowisku rozproszonym, w którym dane są podzielone na wiele urządzeń, a ich komunikacja z urządzeniem centralnym jest ograniczona do określonej liczby bitów.

W statystyce test to procedura określająca, czy hipoteza dotycząca parametru jest prawdziwa i w jakim stopniu można polegać na tym wyniku. Inaczej mówiąc, mierzy niepewność. Kiedy czytamy, że hipoteza „nie jest istotna statystycznie”, oznacza to, że w danych nie znaleziono żadnych dowodów na poparcie tej hipotezy.

„Testy, które opracowujemy w artykule, pozwalają nam osiągnąć najwyższą dokładność dla danej ilości przesyłanych informacji lub minimalną ilość informacji, która zostanie przesłana, aby uzyskać pożądany poziom dokładności” – wyjaśnia profesor Szabo.

Niniejsza praca jest podstawową pracą wykorzystującą idealne warunki matematyczne, ale profesor Szabo pracuje już nad bardziej złożonymi ustawieniami. „Mamy nadzieję, że w dłuższej perspektywie będziemy mogli dysponować wydajniejszymi algorytmami komunikacji, popartymi teoretycznymi gwarancjami” – mówi.

Butund zabo, Lacy Forstein, Harry’ego Van Zantena„,”Optymalne, wielowymiarowe, nieparametryczne testy rozproszone przy ograniczeniach łączności„. Roczniki statystyczne, 51(3): 909–934 (czerwiec 2023 r.). Identyfikator cyfrowy: https://dx.doi.org/10.1214/23-AOS2269.

Zastrzeżenie: AAAS i EurekAlert! Nie ponosimy odpowiedzialności za dokładność biuletynów publikowanych w EurekAlert! Za pośrednictwem instytucji wnoszących wkład lub do wykorzystania jakichkolwiek informacji za pośrednictwem systemu EurekAlert.

„Nieuleczalny myśliciel. Miłośnik jedzenia. Subtelnie czarujący badacz alkoholu. Zwolennik popkultury”.

More Stories

Model sugeruje, że możliwe są podświetlne napędy skrętne

Szybkie sposoby zarządzania ikonami paska menu na komputerze Mac

Wreszcie gracz Super Mario 64 znalazł sposób na otwarcie „nieotwieralnych” drzwi kabiny bez oszukiwania